Tiga Bias Berbahaya AI dan Solusinya

PADA tulisan penulis sebelumnya di Kolom Kompas.com berjudul "Berkaca Kasus Indra Kenz dan Reza Paten: Hati-hati, Artificial Intellegence Jadi Ilmu Palsu" (15/11/2022), telah dibahas bahwa Artificial Intelligence (AI) bisa menjadi ilmu palsu.

Tulisan kali akan diawali dengan tiga bias dari AI yang membahayakan kita semua. Pertama, bias sistemik, yakni ketika AI dihasilkan dari prosedur dan praktik institusi tertentu yang beroperasi dengan cara yang mengakibatkan kelompok sosial tertentu diuntungkan atau disukai, serta yang lain diuntungkan atau direndahkan.

Hal ini tidak harus merupakan akibat dari prasangka atau diskriminasi yang disadari, melainkan dari mayoritas yang mengikuti aturan atau norma yang ada. Rasisme institusional dan seksisme adalah contoh paling umum.

Kedua, bias statistik dan komputasi, yakni berasal dari kesalahan AI yang dihasilkan ketika sampel tidak mewakili populasi.

Bias ini muncul dari kesalahan sistematis yang bertentangan dengan kesalahan acak dan dapat terjadi tanpa adanya prasangka, keberpihakan, atau niat diskriminatif.

Ketiga, bias manusia, yakni kesalahan sistematis dalam pemikiran manusia berdasarkan sejumlah prinsip heuristik dan memprediksi nilai untuk operasi penilaian yang lebih sederhana.

Bias ini sering kali tersirat dan cenderung berhubungan dengan bagaimana individu atau kelompok memandang informasi (seperti keluaran AI otomatis) dalam membuat keputusan atau mengisi informasi yang hilang atau tidak diketahui.

Atas tiga bias ini, penulis mengajak semua pihak menerapkan pendekatan standar COBIT 2019 dalam tata kelola AI, baik sebelum implementasi atau simultan pelaksanaan.

Secara prinsip, tata kelola ini diperlukan di berbagai tingkatan serta sangat penting menjadikan pertimbangan etis sebagai faktor signifikan.

Pencarian ini paralel dilakukan dalam kerangka kerja etis otoritatif guna memanfaatkan kerangka tata kelola AI. Sebab, semakin banyak literatur yang menyarankan potensi bias dalam aplikasi AI yang dirilis.

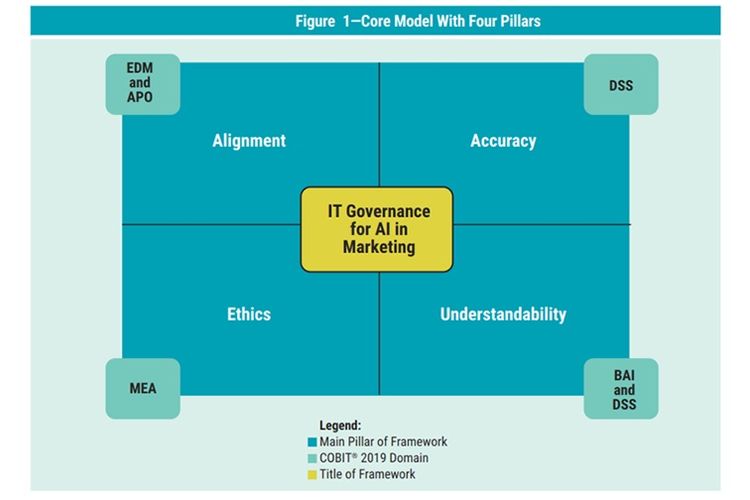

Dengan demikian, empat landasan COBIT 2019 (lihat gambar di bawah) dari model yang dipilih adalah etika (ethics), keselarasan (alligment), akurasi (accuracy), serta dapat dimengerti (understabilty).

Ini dikarenakan integritas informasi sangat penting dalam semua aplikasi ICT serta di sisi lain, harus dapat dimengerti karena banyak dari apa yang terjadi di AI adalah hasil algoritma matematika yang sangat kompleks.

Empat landasan COBIT 2019

Empat landasan COBIT 2019Empat Elemen COBIT 2019 dan Governance Objectice Model

Elemen pertama adalah penyelarasan (alignment). Dalam konteks pemasaran, penyelarasan pemanfaatan AI dengan strategi bisnis, kebutuhan konsumen, dan kesepakatan kontrak sangat penting dilakukan.

Ini memastikan bahwa transparansi pemangku kepentingan ditegakkan dan penggunaan AI tidak bertentangan dengan rasa saling percaya sehingga mengarah pada hasil efektif.

Untuk memberikan pemahaman lebih baik tentang bagaimana masing-masing dari empat pilar terkait domain COBIT 2019, ada berbagai proses dan aktivitas kontrol di bawah setiap kategori.

Secara umum, tujuan baru ini berlaku untuk seluruh perusahaan, tetapi beberapa di antaranya patut mendapat perhatian khusus oleh tim saat mengerjakan inisiatif AI, di mana bias menjadi perhatian.

Contohnya di bawah alligment terdapat proses dan aktivitas kontrol APO15 Managed Values dan APO16 Managed Brand Image and Reputation.

Kedua ini dibuat dengan tujuan spesifik, yakni APO15 mampu mengukuhkan kepemimpinan dalam pengembangan dan implementasi nilai organisasi serta APO16 mampu mengelola persepsi organisasi dari para pihak.

Berikutnya ketepatan (accuracy) adalah nilai AI dalam pemasaran hampir seluruhnya bergantung keakuratan penilaian, prediksi, dan penilaian yang dibuat alat tersebut.

Memastikan bahwa algoritma AI dirancang, dilatih, dan diimplementasikan dengan benar, hal ini sangat penting untuk mempertahankan standar akurasi tinggi yang dapat dipercaya para pemangku kepentingan.

Akurasi ini disertai target DSS07 Managed Integrity (memberikan jaminan ke para pihak bahwa keluaran sistem AI akurat dan tersedia) serta DSS08 Managed Communication (koordinasi komunikasi memastikan sistem AI dikembangkan/dikerjakan untuk keperluan potensial).

Lalu, etika (ethics) adalah pertimbangan etis menjadi yang terdepan di benak banyak pemangku kepentingan.

Di luar etika implisit terkait penyelarasan, organisasi harus mengambil langkah-langkah memastikan bahwa penggunaan AI tidak mengesampingkan masalah tertentu secara berlebihan, terutama dalam bidang pemasaran.

Saat berurusan dengan persuasi dan pengaruh konsumen, organisasi harus memastikan bahwa bahaya dapat dihindari saat mengizinkan AI untuk bertindak secara mandiri.

Kekhawatiran seperti privasi, dampak yang berbeda, diskriminasi, dan bahkan keberlanjutan, harus menjadi fokus perusahaan.

Etika ini terkait target spesifik MEA05 Managed Societal Impact (mengawasi keluaran AI kepada para pihak dari sisi sosial serta menghindari dampak merugikan).

Terakhir, dapat dimengerti (understandability) terkait kompleksitas AI yang memungkinkannya melakukan tugas-tugas independen yang secara historis membutuhkan interaksi manusia dan apa yang mengarah pada penciptaan efek "kotak hitam".

Hal ini selaras dengan target spesifik understandability, yakni BAI12 Managed Black Box atau kepastian semua spek sistem AI guna keperluan potensial terdokumentasi.

Kotak hitam ini terjadi ketika seseorang dapat melihat apa yang masuk ke dalam kotak dan apa yang keluar, tetapi tidak dapat memvisualisasikan (apalagi memahami) salah satu peristiwa yang terjadi di dalam kotak, yaitu algoritma.

Menghindari fenomena ini sangat penting dan memungkinkan eksekutif perusahaan untuk membuat keputusan tepat.

Dengan membuat kontrol yang menjamin pemahaman dan proses AI yang mudah, ada jaminan bahwa pemain kunci perusahaan dapat bereaksi terhadap perubahan di pasar serta masalah apa pun yang mungkin timbul melalui penggunaan AI.

Bagaimana, siapkah Anda dengan bias AI ini?

Simak breaking news dan berita pilihan kami langsung di ponselmu. Pilih saluran andalanmu akses berita Kompas.com WhatsApp Channel : https://www.whatsapp.com/channel/0029VaFPbedBPzjZrk13HO3D. Pastikan kamu sudah install aplikasi WhatsApp ya.